1. 通过知识提炼实现沟通效率的联邦学习

题目:Communication-efficient federated learning via knowledge distillation

杂志:Nature Communications

IF: 14.92

时间:19 April 2022

链接:https://www.nature.com/articles/s41467-022-29763-x

摘要

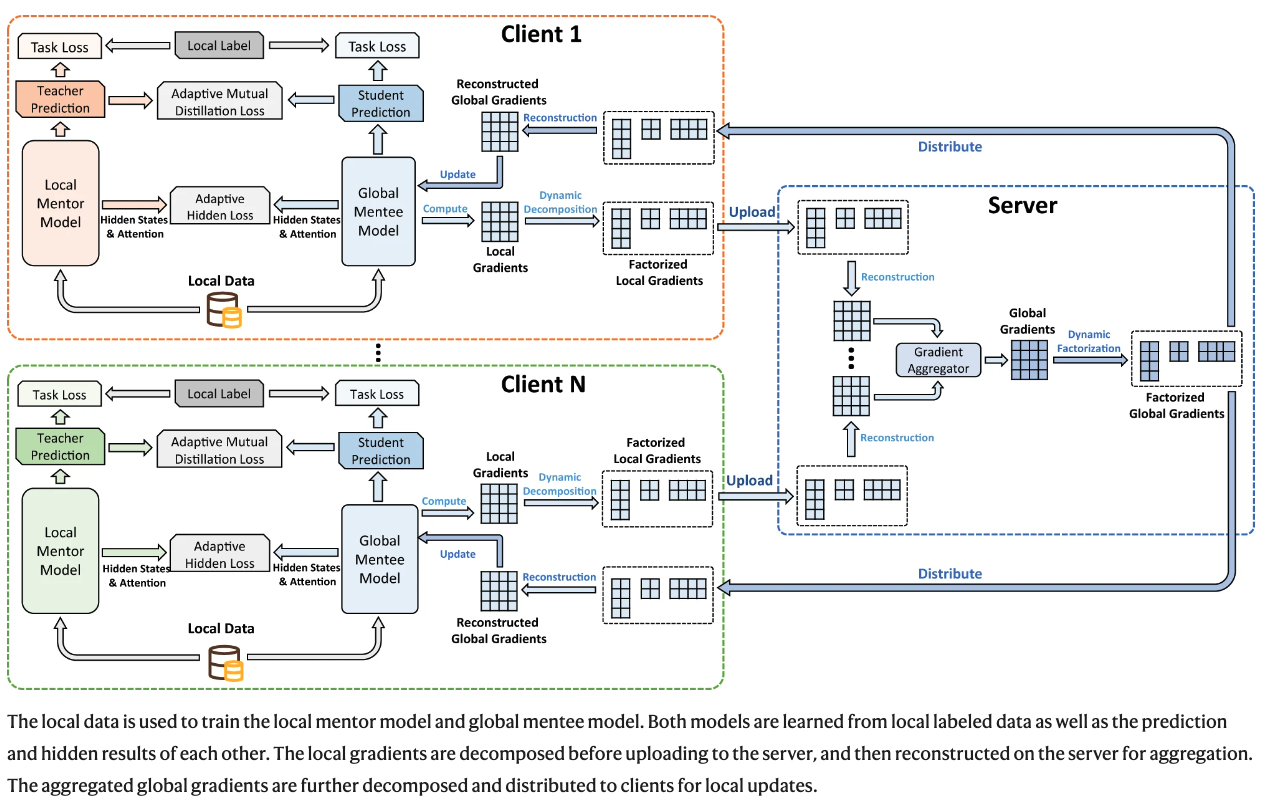

联邦学习(Federated learning)是一种保护隐私的机器学习技术,从分散的数据中训练人工智能模型,它通过在模型学习的每个迭代中交流局部模型更新而不是原始数据,实现对隐私数据的利用。然而,如果模型更新包含众多参数,那么模型更新可能会非常大,而且模型训练需要很多轮通信。联邦学习中巨大的通信成本导致了客户端的沉重开销和高环境负担。在这里,我们提出了一种名为FedKD的联邦学习学习方法,该方法基于自适应相互知识提炼和动态梯度压缩技术(based on adaptive mutual knowledge distillation and dynamic gradient compression techniques),既节省通信又有效。FedKD在三个需要保护隐私的不同场景中得到了验证,表明它可以最大限度地减少94.89%的通信成本,并取得与集中式模型学习相竞争的结果。FedKD为在许多场景中有效地部署保护隐私的智能系统提供了可能性,如智能医疗和个性化。

该方法主要集中在跨语境的联合学习上,在这种情况下,客户端拥有比个人设备相对更丰富的计算资源和更大的本地数据量。在FedKD中,客户机和服务器之间不直接交流大模型,而是有一个小模型(mentee)和一个大模型(mentor)相互学习和提炼知识,其中只有mentee模型被不同的客户机共享并协同学习,这可以有效降低通信成本。这样一来,不同的客户拥有不同的本地导师模型,可以更好地适应本地数据集的特点,实现个性化的模型学习。受人类学习中的Protégé效应29(”我们一边教,一边学”,Seneca the Younger)的启发,我们提出了一种自适应的相互提炼方法,使本地导师和被导师模型能够相互学习从他们预测的软标签和中间结果中提炼出来的知识,其中提炼强度由他们预测的正确性自适应控制。此外,为了进一步降低交换被指导者模型更新时的通信成本,我们引入了一种基于奇异值分解(SVD)的动态梯度近似方法,以动态精度压缩通信的梯度,这可以在通信成本和模型精度之间实现一个有希望的权衡。

2. 用于保护隐私的个人化的联合图神经网络框架

题目:A federated graph neural network framework for privacy-preserving personalization

杂志:Nature Communications

IF: 14.92

时间:02 June 2022

链接:https://www.nature.com/articles/s41467-022-30714-9

摘要

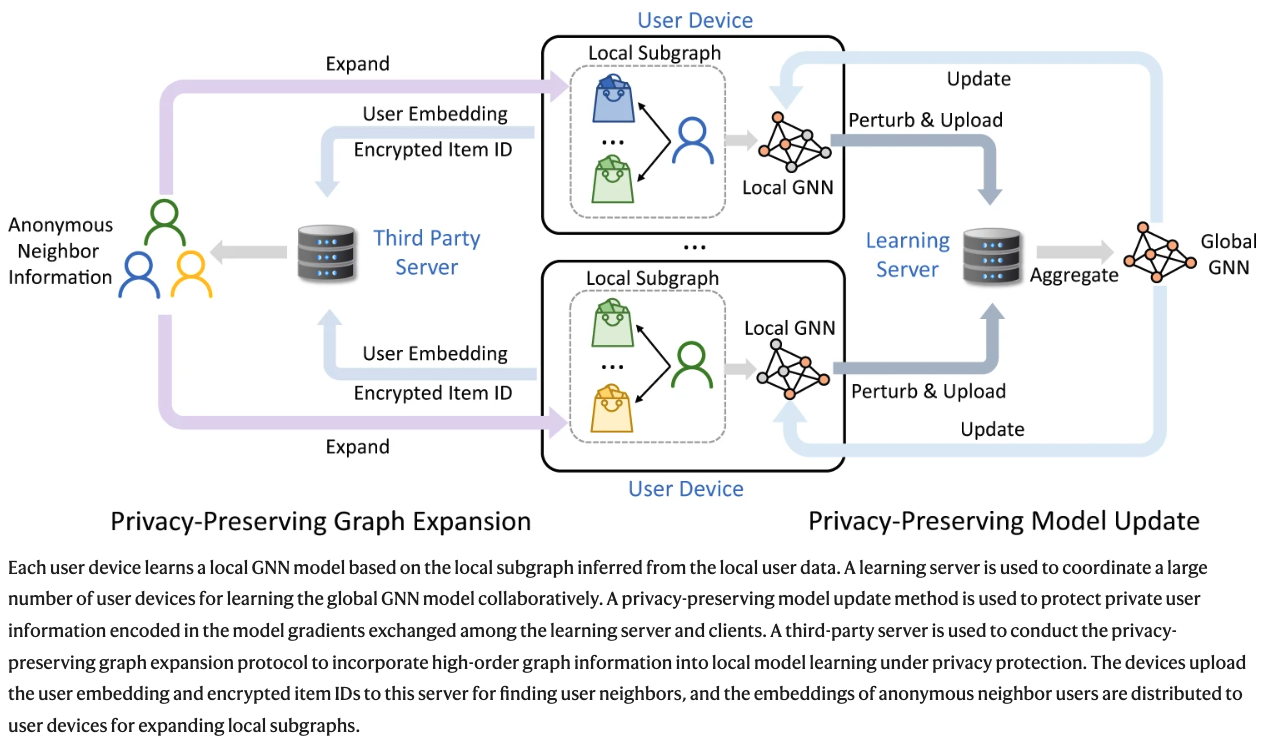

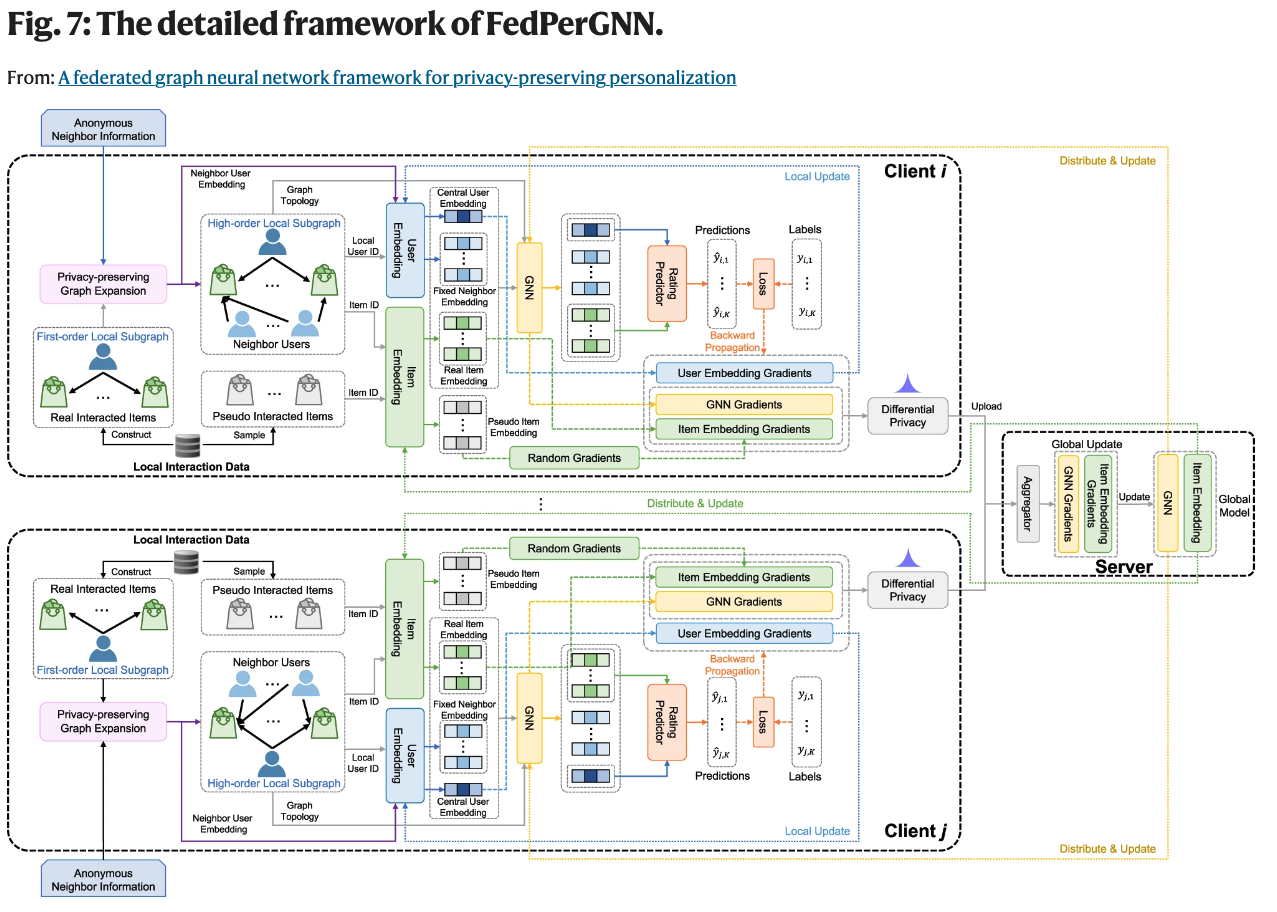

图神经网络(Graph neural network, GNN)能有效地模拟高阶互动,并已被广泛用于各种个性化应用,如推荐。然而,主流的个性化方法依赖于全局图上的集中式GNN学习,由于用户数据的隐私敏感性质,这存在相当大的隐私风险。在这里,我们提出了一个名为FedPerGNN的联合GNN框架,用于有效和保护隐私的个性化。通过一个保护隐私的模型更新方法,我们可以根据从本地数据推断出的分散的图来协作训练GNN模型。为了进一步利用本地互动以外的图信息,我们引入了一个保护隐私的图扩展协议,在保护隐私的前提下纳入高阶信息。在不同场景下对六个数据集进行的个性化实验结果表明,在良好的隐私保护下,FedPerGNN比最先进的联合个性化方法的误差低4.0%~9.6%。FedPerGNN为以保护隐私的方式挖掘分散的图数据,实现负责任的智能个性化提供了一个很好的方向。

这两篇文章来自于同一作者,作者的github链接:https://github.com/wuch15